Pytanie 1

Aby zrealizować iloczyn logiczny z uwzględnieniem negacji, jaki funktor powinno się zastosować?

Wynik: 23/40 punktów (57,5%)

Wymagane minimum: 20 punktów (50%)

Aby zrealizować iloczyn logiczny z uwzględnieniem negacji, jaki funktor powinno się zastosować?

Jaką jednostką określa się szybkość przesyłania danych w sieciach komputerowych?

Zasilacz UPS o mocy nominalnej 480 W nie powinien być używany do zasilania

Jak nazywa się topologia fizyczna, w której każdy węzeł łączy się bezpośrednio ze wszystkimi innymi węzłami?

Aby podłączyć drukarkę igłową o wskazanych parametrach do komputera, należy umieścić kabel dołączony do drukarki w porcie

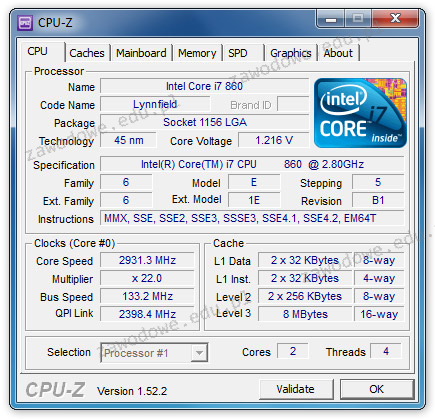

W dokumentacji technicznej procesora producent umieścił wyniki testu, który został wykonany przy użyciu programu CPU-Z. Z tych danych wynika, że procesor dysponuje

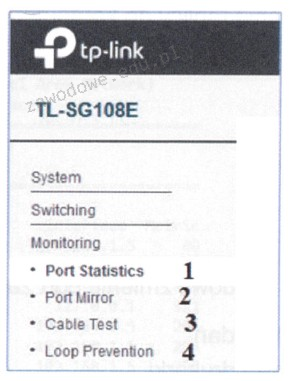

Aby sprawdzić stan podłączonego kabla oraz zdiagnozować odległość do miejsca awarii w sieci, należy użyć funkcji przełącznika oznaczonej numerem

Podczas pracy dysk twardy wydaje stukanie, a uruchamianie systemu oraz odczyt danych są znacznie spowolnione. W celu naprawienia tej awarii, po wykonaniu kopii zapasowej danych na zewnętrznym nośniku należy

Jakie elementy wchodzą w skład dokumentacji powykonawczej?

Jaką maksymalną prędkość transferu danych umożliwia interfejs USB 3.0?

Jakie będzie całkowite koszty materiałów potrzebnych do zbudowania sieci lokalnej dla 6 komputerów, jeśli do realizacji sieci wymagane są 100 m kabla UTP kat. 5e oraz 20 m kanału instalacyjnego? Ceny komponentów sieci zostały przedstawione w tabeli

| Elementy sieci | j.m. | cena brutto |

|---|---|---|

| Kabel UTP kat. 5e | m | 1,00 zł |

| Kanał instalacyjny | m | 8,00 zł |

| Gniazdo komputerowe | szt. | 5,00 zł |

Program o nazwie dd, którego przykład zastosowania przedstawiono w systemie Linux, umożliwia

Jak nazywa się protokół bazujący na architekturze klient-serwer oraz na modelu żądanie-odpowiedź, który jest używany do transferu plików?

Usługi na serwerze są konfigurowane za pomocą

Złośliwe programy komputerowe, które potrafią replikować się same i wykorzystują luki w systemie operacyjnym, a także mają zdolność modyfikowania oraz uzupełniania swojej funkcjonalności, nazywamy

Norma opisująca standard transmisji Gigabit Ethernet to

Po włączeniu komputera wyświetlił się komunikat: Non-system disk or disk error. Replace and strike any key when ready. Co może być tego przyczyną?

Zbiór zasad określających metodę wymiany danych w sieci to

Złącze IrDA służy do bezprzewodowej komunikacji i jest

Komunikat o błędzie KB/Interface, wyświetlany na monitorze komputera podczas BIOS POST firmy AMI, wskazuje na problem

Na rysunku można zobaczyć schemat topologii fizycznej, która jest kombinacją topologii

Program, który ocenia wydajność zestawu komputerowego, to

Jakie są prędkości przesyłu danych w sieciach FDDI (ang. Fiber Distributed Data Interface) wykorzystujących technologię światłowodową?

Na przedstawionym rysunku widoczna jest karta rozszerzeń z systemem chłodzenia

Jakie rozwiązanie należy wdrożyć i prawidłowo ustawić, aby chronić lokalną sieć komputerową przed atakami typu Smurf pochodzącymi z Internetu?

Funkcja System Image Recovery dostępna w zaawansowanych opcjach uruchamiania systemu Windows 7 pozwala na

Wskaż rodzaj wtyczki zasilającej, którą należy połączyć z napędem optycznym podczas montażu komputera.

Nowe komponenty komputerowe, takie jak dyski twarde czy karty graficzne, są umieszczane w metalizowanych opakowaniach foliowych, których głównym celem jest zabezpieczenie

W dokumentacji technicznej wydajność głośnika połączonego z komputerem wyraża się w jednostce:

Zamiana baterii jest jedną z czynności związanych z użytkowaniem

System S.M.A.R.T. jest używany do nadzorowania funkcjonowania i identyfikowania problemów

Aby zminimalizować różnice w kolorach pomiędzy zeskanowanymi obrazami prezentowanymi na monitorze a ich wersjami oryginalnymi, należy przeprowadzić

Który standard IEEE 802.3 powinien być użyty w sytuacji z zakłóceniami elektromagnetycznymi, jeżeli odległość między punktem dystrybucyjnym a punktem abonenckim wynosi 200 m?

Aby zmienić system plików na dysku z FAT32 na NTFS w Windows XP, należy użyć programu

Jakie urządzenie służy do połączenia 6 komputerów w ramach sieci lokalnej?

Każdy następny router IP na drodze pakietu

Które z wymienionych mediów nie jest odpowiednie do przesyłania danych teleinformatycznych?

NOWY, GOTOWY, OCZEKUJĄCY oraz AKTYWNY to

Który z wymienionych parametrów procesora AMD APU A10 5700 3400 nie ma bezpośredniego wpływu na jego wydajność?

| Częstotliwość | 3400 MHz |

| Proces technologiczny | 32 nm |

| Architektura | 64 bit |

| Ilość rdzeni | 4 |

| Ilość wątków | 4 |

| Pojemność pamięci L1 (instrukcje) | 2x64 kB |

| Pojemność pamięci L1 (dane) | 4x16 kB |

| Pojemność Pamięci L2 | 2x2 MB |

Aby zapewnić użytkownikom Active Directory możliwość logowania oraz dostęp do zasobów tej usługi w sytuacji awarii kontrolera domeny, co należy zrobić?