Pytanie 1

Po zauważeniu przypadkowego skasowania istotnych danych na dysku, najlepszym sposobem na odzyskanie usuniętych plików jest

Wynik: 28/40 punktów (70,0%)

Wymagane minimum: 20 punktów (50%)

Po zauważeniu przypadkowego skasowania istotnych danych na dysku, najlepszym sposobem na odzyskanie usuniętych plików jest

Recykling można zdefiniować jako

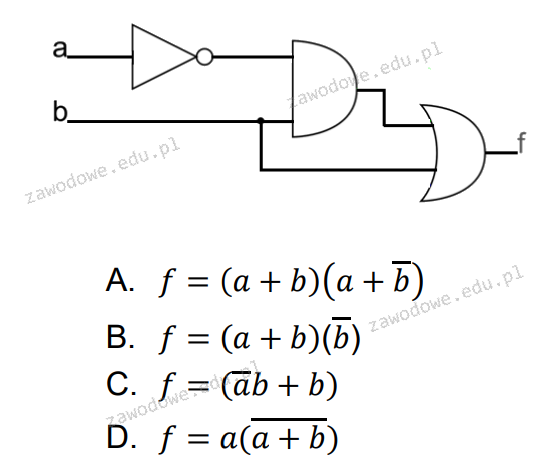

Jaką funkcję wykonuje zaprezentowany układ?

W załączonej ramce przedstawiono opis technologii

| Technologia ta to rewolucyjna i nowatorska platforma, która pozwala na inteligentne skalowanie wydajności podsystemu graficznego poprzez łączenie mocy kilku kart graficznych NVIDIA pracujących na płycie głównej. Dzięki wykorzystaniu zastrzeżonych algorytmów oraz wbudowanej w każdy z procesorów graficznych NVIDIA dedykowanej logiki sterującej, która odpowiada za skalowanie wydajności, technologia ta zapewnia do 2 razy (w przypadku dwóch kart) lub 2,8 razy (w przypadku trzech kart) wyższą wydajność niż w przypadku korzystania z pojedynczej karty graficznej. |

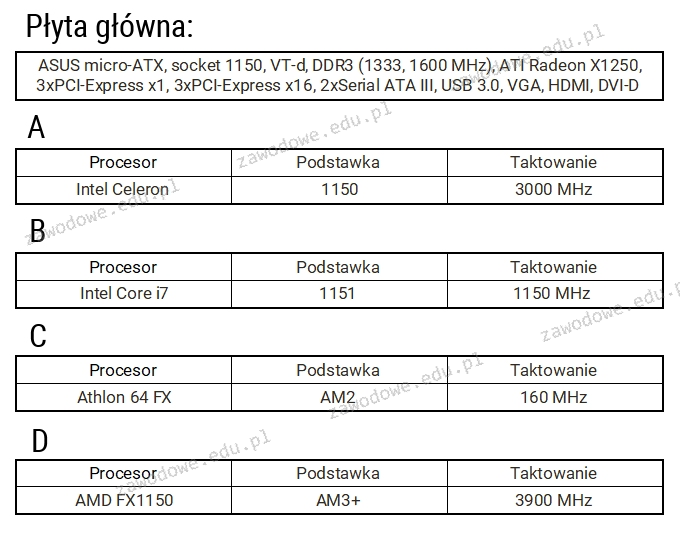

Jaki procesor pasuje do płyty głównej o podanej specyfikacji?

Narzędzia do dostosowywania oraz Unity Tweak Tool to aplikacje w systemie Linux przeznaczone do

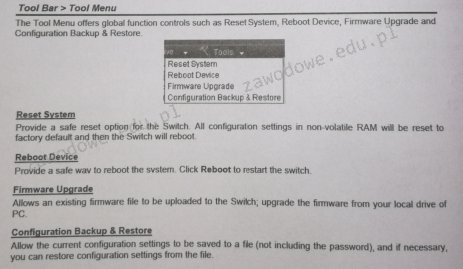

Którą opcję w menu przełącznika należy wybrać, aby przywrócić ustawienia do wartości fabrycznych?

Miarą wyrażaną w decybelach, która określa różnicę pomiędzy mocą sygnału wysyłanego w parze zakłócającej a mocą sygnału generowanego w parze zakłócanej, jest

Aby zmienić istniejące konto użytkownika przy użyciu polecenia net user oraz wymusić reset hasła po kolejnej sesji logowania użytkownika, jaki parametr należy dodać do tego polecenia?

W systemie działającym w trybie wielozadaniowości z wywłaszczeniem program, który zatrzymał się

Z analizy danych przedstawionych w tabeli wynika, że efektywna częstotliwość pamięci DDR SDRAM wynosi 184 styki 64-bitowa magistrala danych Pojemność 1024 MB Przepustowość 3200 MB/s

W którym miejscu w edytorze tekstu należy wprowadzić tekst lub ciąg znaków, który ma być widoczny na wszystkich stronach dokumentu?

Jakie miejsce nie jest zalecane do przechowywania kopii zapasowej danych z dysku twardego komputera?

Aby w systemie Linux wykonać kopię zapasową określonych plików, należy wprowadzić w terminalu polecenie programu

W interfejsie graficznym systemów Ubuntu lub SuSE Linux, aby zainstalować aktualizacje programów systemowych, można zastosować aplikacje

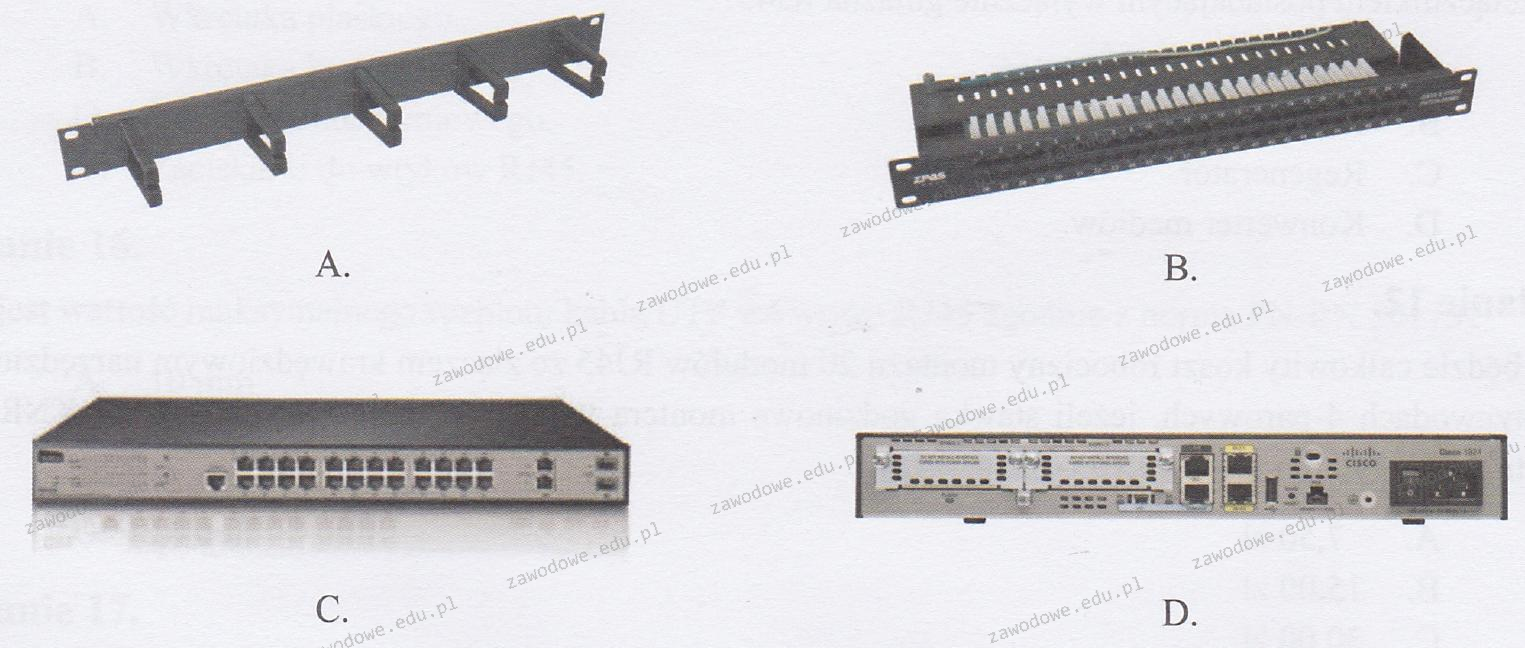

Na którym obrazku przedstawiono panel krosowniczy?

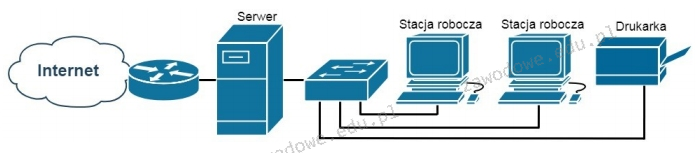

Która funkcja serwera Windows umożliwia użytkownikom końcowym sieci pokazanej na rysunku dostęp do Internetu?

Jaki adres IPv6 jest stosowany jako adres link-local w procesie autokonfiguracji urządzeń?

Najwyższą prędkość transmisji danych w sieciach bezprzewodowych zapewnia standard

Jakie jest ciało odpowiedzialne za publikację dokumentów RFC (Request For Comments), które określają zasady rozwoju Internetu?

W systemie Windows 7 aby skopiować folder c:\test wraz z jego podfolderami na dysk zewnętrzny f:\, należy zastosować polecenie

Który z poniższych protokołów reprezentuje protokół warstwy aplikacji w modelu ISO/OSI?

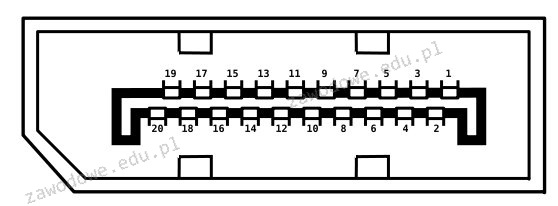

Aby połączyć projektor multimedialny z komputerem, złącze, którego NIEDOZWOLONO użyć to

Jak określa się technologię stworzoną przez firmę NVIDIA, która pozwala na łączenie kart graficznych?

Przy użyciu urządzenia zobrazowanego na rysunku możliwe jest sprawdzenie działania

Standard zwany IEEE 802.11, używany w lokalnych sieciach komputerowych, określa typ sieci:

W zestawieniu przedstawiono istotne parametry techniczne dwóch typów interfejsów. Z powyższego wynika, że SATA w porównaniu do ATA charakteryzuje się

| Table Comparison of parallel ATA and SATA | ||

|---|---|---|

| Parallel ATA | SATA 1.5 Gb/s | |

| Bandwidth | 133 MB/s | 150 MB/s |

| Volts | 5V | 250 mV |

| Number of pins | 40 | 7 |

| Cable length | 18 in. (45.7 cm) | 39 in. (1 m) |

Rodzaje ataków mających na celu zakłócenie funkcjonowania aplikacji oraz procesów w urządzeniach sieciowych to ataki klasy

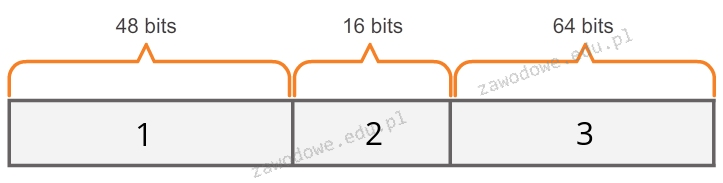

Które bity w 48-bitowym adresie MAC identyfikują producenta?

Taśma drukująca stanowi kluczowy materiał eksploatacyjny w drukarce

Użytkownicy sieci Wi-Fi zauważyli zakłócenia oraz częste przerwy w połączeniu. Przyczyną tej sytuacji może być

Jakie są korzyści płynące z użycia systemu plików NTFS?

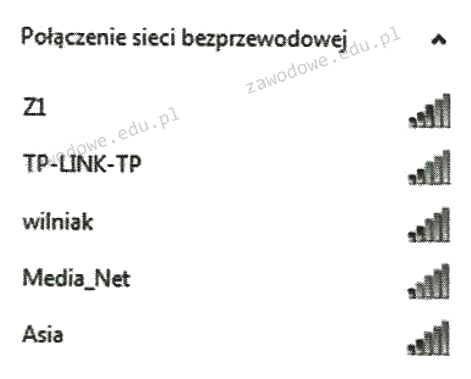

Użytkownik laptopa z systemem Windows 7 widzi dostępne sieci Wi-Fi, jak przedstawiono na ilustracji. Przy konfiguracji połączenia z siecią Z1 musi wprowadzić

Na płycie głównej z chipsetem Intel 865G

Jakie polecenie w systemach Windows należy użyć, aby ustawić statyczny adres IP w konsoli poleceń?

Standardowo, w systemie Linux, twardy dysk w standardzie SATA jest oznaczany jako

Na ilustracji zaprezentowano sieć komputerową w układzie

Który z protokołów służy do synchronizacji czasu?

Na ilustracji pokazano złącze:

Jaką sekwencję mają elementy adresu globalnego IPv6 typu unicast ukazanym na diagramie?