Pytanie 1

W jakim urządzeniu elektronicznym znajduje się układ RAMDAC?

Wynik: 25/40 punktów (62,5%)

Wymagane minimum: 20 punktów (50%)

W jakim urządzeniu elektronicznym znajduje się układ RAMDAC?

Jaką kwotę będzie trzeba zapłacić za wymianę karty graficznej w komputerze, jeżeli jej koszt wynosi 250zł, czas wymiany to 80 minut, a każda rozpoczęta roboczogodzina to 50zł?

Z analizy oznaczenia pamięci DDR3 PC3-16000 można wywnioskować, że ta pamięć:

Pamięć oznaczona jako PC3200 nie jest kompatybilna z magistralą

Przyczyną niekontrolowanego wypełnienia przestrzeni na dysku może być

Najczęstszym powodem, dla którego toner rozmazuje się na wydrukach z drukarki laserowej, jest

Główny sposób zabezpieczania danych w sieciach komputerowych przed dostępem nieautoryzowanym to

Ile adresów można przypisać urządzeniom działającym w sieci o adresie IP 192.168.20.0/26?

W systemach Windows, aby określić, w którym miejscu w sieci zatrzymał się pakiet, stosuje się komendę

Podczas próby nawiązania połączenia z serwerem FTP, uwierzytelnienie anonimowe nie powiodło się, natomiast logowanie za pomocą loginu i hasła zakończyło się sukcesem. Co może być przyczyną tej sytuacji?

Które medium transmisyjne umożliwia izolację galwaniczną pomiędzy systemami przesyłu danych?

Protokół Datagramów Użytkownika (UDP) należy do kategorii

Zgodnie z normą 802.3u technologia sieci FastEthernet 100Base-FX stosuje

Jakie urządzenie należy zastosować do pomiaru mocy zużywanej przez komputer?

Jakie polecenie służy do przeprowadzania aktualizacji systemu operacyjnego Linux korzystającego z baz RPM?

Użycie polecenia net accounts w Wierszu poleceń systemu Windows, które ustawia maksymalny czas ważności hasła, wymaga zastosowania opcji

Kiedy użytkownik wprowadza w wierszu poleceń komendę ping www.onet.pl, otrzymuje komunikat: "Żądanie polecenia ping nie może znaleźć hosta www.onet.pl. Sprawdź nazwę i ponów próbę." Natomiast po wpisaniu polecenia ping 213.180.141.140 (adres IP serwera www.onet.pl) użytkownik otrzymuje odpowiedź z serwera. Jakie mogą być przyczyny tego zjawiska?

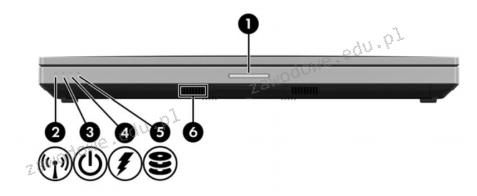

Na ilustracji widoczne jest oznaczenie sygnalizacji świetlnej w dokumentacji technicznej laptopa. Wskaż numer odpowiadający kontrolce, która zapala się podczas ładowania akumulatora?

W systemie Linux do obserwacji działania sieci, urządzeń sieciowych oraz serwerów można zastosować aplikację

Aby serwer mógł przesyłać dane w zakresach częstotliwości 2,4 GHz oraz 5 GHz, konieczne jest zainstalowanie w nim karty sieciowej działającej w standardzie

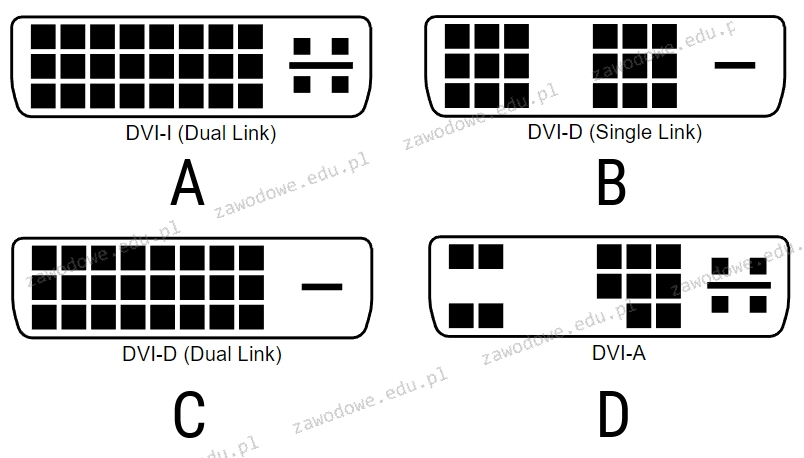

Który standard złącza DVI pozwala na przesyłanie jedynie sygnału analogowego?

Komputer K1 jest połączony z interfejsem G0 rutera, a komputer K2 z interfejsem G1 tego samego urządzenia. Na podstawie danych przedstawionych w tabeli, określ właściwy adres bramy dla komputera K2.

| Interfejs | Adres IP | Maska |

|---|---|---|

| G0 | 172.16.0.1 | 255.255.0.0 |

| G1 | 192.168.0.1 | 255.255.255.0 |

Protokół SNMP (Simple Network Management Protocol) jest wykorzystywany do

Aby chronić sieć WiFi przed nieautoryzowanym dostępem, należy między innymi

Po włączeniu komputera na ekranie wyświetlił się komunikat "Non-system disk or disk error. Replace and strike any key when ready". Możliwą przyczyną tego może być

ACPI to interfejs, który umożliwia

Jak skonfigurować czas wyczekiwania na wybór systemu w programie GRUB, zanim domyślny system operacyjny zostanie uruchomiony?

W sieciach komputerowych miarą prędkości przesyłu danych jest

Do pielęgnacji elementów łożyskowych oraz ślizgowych w urządzeniach peryferyjnych wykorzystuje się

Zasada dostępu do medium CSMA/CA jest wykorzystywana w sieci o specyfikacji

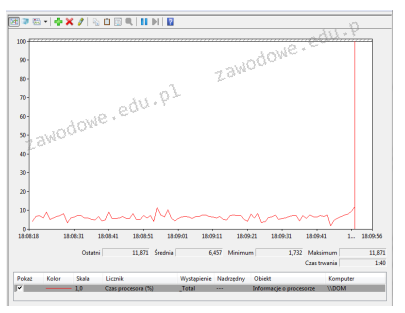

Aby zainicjować w systemie Windows oprogramowanie do monitorowania wydajności komputera przedstawione na ilustracji, należy otworzyć

Metoda przesyłania danych między urządzeniem CD/DVD a pamięcią komputera w trybie bezpośredniego dostępu do pamięci to

Podczas konfiguracji nowego routera, użytkownik został poproszony o skonfigurowanie WPA2. Czego dotyczy to ustawienie?

Jakim poleceniem w systemie Linux można utworzyć nowych użytkowników?

Urządzenie trwale zainstalowane u abonenta, które zawiera zakończenie poziomego okablowania strukturalnego, to

Adres IP przydzielony komputerowi pozwala odbiorcy pakietu IP na odróżnienie identyfikatorów

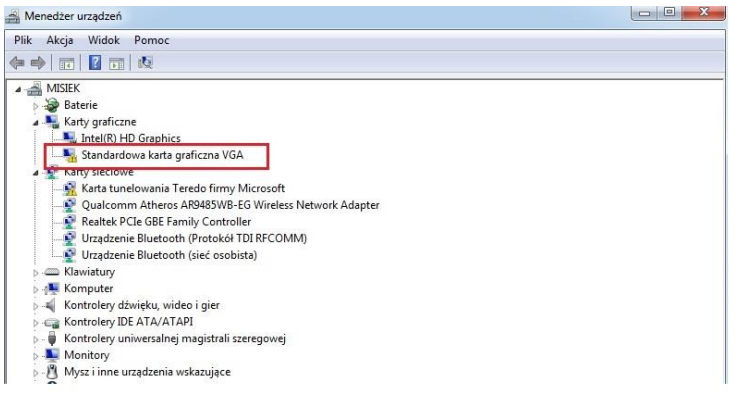

Jakie kroki powinien podjąć użytkownik, aby wyeliminować błąd zaznaczony na rysunku ramką?

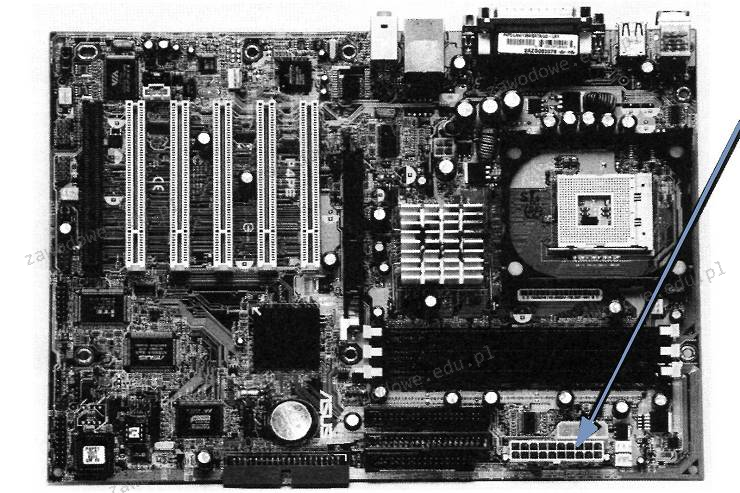

Na zdjęciu widać płytę główną komputera. Strzałka wskazuje na

Wykonanie polecenia tar –xf dane.tar w systemie Linux spowoduje

Który z poniższych mechanizmów zapewni najwyższy stopień ochrony sieci bezprzewodowych w standardzie 802.11n?