Pytanie 1

Jakie środowisko powinien wybrać administrator sieci, aby zainstalować serwer dla stron WWW w systemie Linux?

Wynik: 34/40 punktów (85,0%)

Wymagane minimum: 20 punktów (50%)

Jakie środowisko powinien wybrać administrator sieci, aby zainstalować serwer dla stron WWW w systemie Linux?

Jak nazywa się atak na sieć komputerową, który polega na przechwytywaniu przesyłanych w niej pakietów?

Dokument mający na celu przedstawienie oferty cenowej dla inwestora dotyczącej przeprowadzenia robót instalacyjnych w sieci komputerowej, to

Termin określający zdolność do rozbudowy sieci to

Jakie polecenie pozwala na przeprowadzenie aktualizacji do nowszej wersji systemu Ubuntu Linux?

W systemie Linux, gdzie przechowywane są hasła użytkowników?

Wskaż technologię stosowaną do zapewnienia dostępu do Internetu w połączeniu z usługą telewizji kablowej, w której światłowód oraz kabel koncentryczny pełnią rolę medium transmisyjnego

Aby utworzyć obraz dysku twardego, można skorzystać z programu

Jaką klasę adresów IP reprezentuje publiczny adres 130.140.0.0?

GRUB, LILO, NTLDR to

Jaka jest maksymalna liczba komputerów, które mogą być zaadresowane w podsieci z adresem 192.168.1.0/25?

Który z poniższych elementów jest częścią mechanizmu drukarki atramentowej?

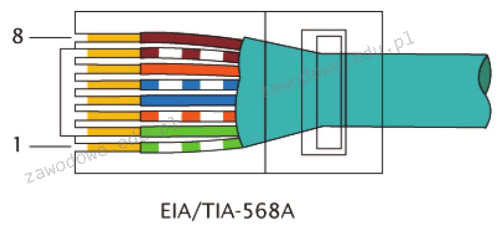

W standardzie Ethernet 100BaseTX do przesyłania danych używane są żyły kabla UTP podłączone do pinów

Jakie zadanie pełni router?

W celu zbudowania sieci komputerowej w danym pomieszczeniu wykorzystano 25 metrów kabli UTP, 5 gniazd RJ45 oraz odpowiednią liczbę wtyków RJ45 potrzebnych do stworzenia 5 kabli połączeniowych typu patchcord. Jaki jest całkowity koszt zastosowanych materiałów do budowy sieci? Ceny jednostkowe materiałów są przedstawione w tabeli.

| Material | Jednostka miary | Cena |

|---|---|---|

| Skrętka UTP | m | 1 zł |

| Gniazdo RJ45 | szt. | 10 zł |

| Wtyk RJ45 | szt. | 50 gr |

Aby zapewnić bezpieczną komunikację terminalową z serwerem, powinno się skorzystać z połączenia z użyciem protokołu

Kiedy dysze w drukarce atramentowej wyschną z powodu długotrwałych przerw w użytkowaniu, co powinno się najpierw wykonać?

Technik serwisowy zrealizował w ramach zlecenia działania wymienione w zestawieniu. Całkowity koszt zlecenia obejmuje cenę usług wymienionych w zestawieniu oraz wynagrodzenie serwisanta, którego stawka godzinowa wynosi 60,00 zł netto. Oblicz całkowity koszt zlecenia brutto. Stawka VAT na usługi wynosi 23%

| LP | Czynność | Czas wykonania w minutach | Cena usługi netto w zł |

|---|---|---|---|

| 1. | Instalacja i konfiguracja programu | 35 | 20,00 |

| 2. | Wymiana płyty głównej | 80 | 50,00 |

| 3. | Wymiana karty graficznej | 30 | 25,00 |

| 4. | Tworzenie kopii zapasowej i archiwizacja danych | 65 | 45,00 |

| 5. | Konfiguracja rutera | 30 | 20,00 |

Aby zapewnić, że komputer uzyska od serwera DHCP określony adres IP, należy na serwerze zdefiniować

Gdy wykonanie polecenia ping 127.0.0.1 nie przynosi żadnej odpowiedzi, to

Który standard Gigabit Ethernet pozwala na tworzenie segmentów sieci o długości 550 m lub 5000 m przy prędkości transmisji 1 Gb/s?

Komputer powinien działać jako serwer w sieci lokalnej, umożliwiając innym komputerom dostęp do Internetu poprzez podłączenie do gniazda sieci rozległej za pomocą kabla UTP Cat 5e. Na chwilę obecną komputer jest jedynie połączony ze switchem sieci lokalnej również kablem UTP Cat 5e oraz nie dysponuje innymi portami 8P8C. Jakiego komponentu musi on koniecznie nabrać?

W jaki sposób powinny być skonfigurowane uprawnienia dostępu w systemie Linux, aby tylko właściciel mógł wprowadzać zmiany w wybranym katalogu?

Tworzenie zaszyfrowanych połączeń pomiędzy hostami przez publiczną sieć Internet, wykorzystywane w rozwiązaniach VPN (Virtual Private Network), to

Aby stworzyć las w strukturze katalogów AD DS (Active Directory Domain Services), konieczne jest utworzenie przynajmniej

Jakie narzędzie w systemie Windows Server umożliwia zarządzanie zasadami grupy?

Przydzielanie przestrzeni dyskowej w systemach z rodziny Windows

Topologia fizyczna sieci, w której wykorzystywane są fale radiowe jako medium transmisyjne, nosi nazwę topologii

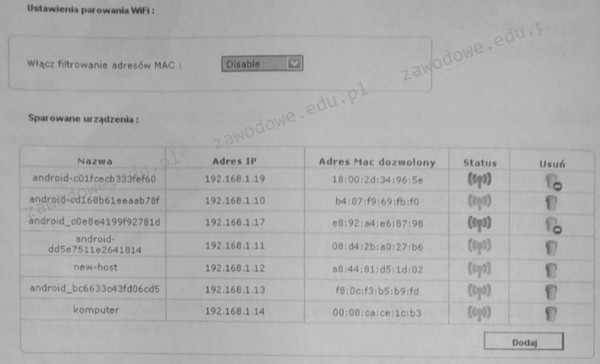

Schemat ilustruje ustawienia urządzenia WiFi. Wskaż, które z poniższych stwierdzeń na temat tej konfiguracji jest prawdziwe?

Który standard w sieciach LAN określa dostęp do medium poprzez wykorzystanie tokenu?

Jakie jednostki stosuje się do wyrażania przesłuchu zbliżonego NEXT?

W sekcji zasilania monitora LCD, powiększone kondensatory elektrolityczne mogą prowadzić do uszkodzenia

ACPI to interfejs, który umożliwia

Użytkownik dysponuje komputerem o podanej konfiguracji i systemie Windows 7 Professional 32bit. Która z opcji modernizacji komputera NIE przyczyni się do zwiększenia wydajności?

| Płyta główna | ASRock Z97 Anniversary Z97 DualDDR3-1600 SATA3 RAID HDMI ATX z czterema slotami DDR3 i obsługą RAID poziomu 0,1 |

| Procesor | i3 |

| Pamięć | 1 x 4 GB DDR3 |

| HDD | 2 x 1 TB |

Jakie polecenie w systemie Windows służy do monitorowania bieżących połączeń sieciowych?

Adres IP lokalnej podsieci komputerowej to 172.16.10.0/24. Komputer1 posiada adres IP 172.16.0.10, komputer2 - 172.16.10.100, a komputer3 - 172.16.255.20. Który z wymienionych komputerów należy do tej podsieci?

Jaką maskę domyślną posiada adres IP klasy B?

W którym trybie działania procesora Intel x86 uruchamiane były aplikacje 16-bitowe?

Podstawowym zadaniem mechanizmu Plug and Play jest

Zjawisko przenikania, które ma miejsce w sieciach komputerowych, polega na