Pytanie 1

Jaki protokół posługuje się portami 20 oraz 21?

Wynik: 34/40 punktów (85,0%)

Wymagane minimum: 20 punktów (50%)

Jaki protokół posługuje się portami 20 oraz 21?

Adapter USB do LPT można zastosować w sytuacji, gdy występuje niezgodność złączy podczas podłączania starszych modeli

Karta sieciowa w standardzie Fast Ethernet umożliwia przesył danych z maksymalną prędkością

Który z poniższych protokołów służy do zarządzania urządzeniami w sieciach?

Przesyłanie informacji przy użyciu fal radiowych w pasmie ISM odbywa się w standardzie

Na dysku należy umieścić 100 tysięcy oddzielnych plików, z których każdy ma rozmiar 2570 bajtów. W takim przypadku, zapisane pliki będą zajmować najmniej miejsca na dysku z jednostką alokacji wynoszącą

Jakiego rodzaju złącze powinna mieć płyta główna, aby umożliwić zainstalowanie karty graficznej przedstawionej na rysunku?

Który z poniższych adresów IPv4 należy do klasy C?

Firma Dyn, której serwery DNS zostały zaatakowane, przyznała, że część tego ataku … miała miejsce z użyciem różnych urządzeń podłączonych do sieci. Ekosystem kamer, czujników i kontrolerów określany ogólnie jako 'Internet rzeczy' został wykorzystany przez cyberprzestępców jako botnet − sieć maszyn-zombie. Jakiego rodzaju atak jest opisany w tym cytacie?

Wynikiem dodawania dwóch liczb binarnych 1101011 oraz 1001001 jest liczba w systemie dziesiętnym

Wskaż błędne twierdzenie dotyczące Active Directory?

Użytkownik systemu Windows może skorzystać z polecenia taskmgr, aby

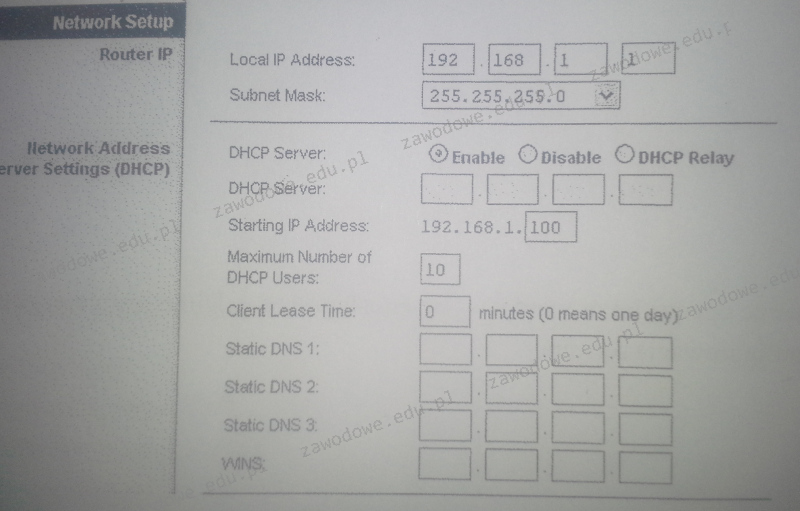

Na przedstawionym zrzucie panelu ustawień rutera można zauważyć, że serwer DHCP

Rekord startowy dysku twardego w komputerze to

Aby stworzyć bezpieczny wirtualny tunel pomiędzy dwoma komputerami korzystającymi z Internetu, należy użyć technologii

Jaką funkcję serwera z grupy Windows Server trzeba dodać, aby serwer mógł realizować usługi rutingu?

W systemie Windows 7 program Cipher.exe w trybie poleceń jest używany do

Który z wymienionych parametrów procesora AMD APU A10 5700 3400 nie ma bezpośredniego wpływu na jego wydajność?

| Częstotliwość | 3400 MHz |

| Proces technologiczny | 32 nm |

| Architektura | 64 bit |

| Ilość rdzeni | 4 |

| Ilość wątków | 4 |

| Pojemność pamięci L1 (instrukcje) | 2x64 kB |

| Pojemność pamięci L1 (dane) | 4x16 kB |

| Pojemność Pamięci L2 | 2x2 MB |

Na stabilność obrazu w monitorach CRT istotny wpływ ma

Jaki typ grupy jest automatycznie przypisany dla nowo tworzonej grupy w kontrolerze domeny systemu Windows Server?

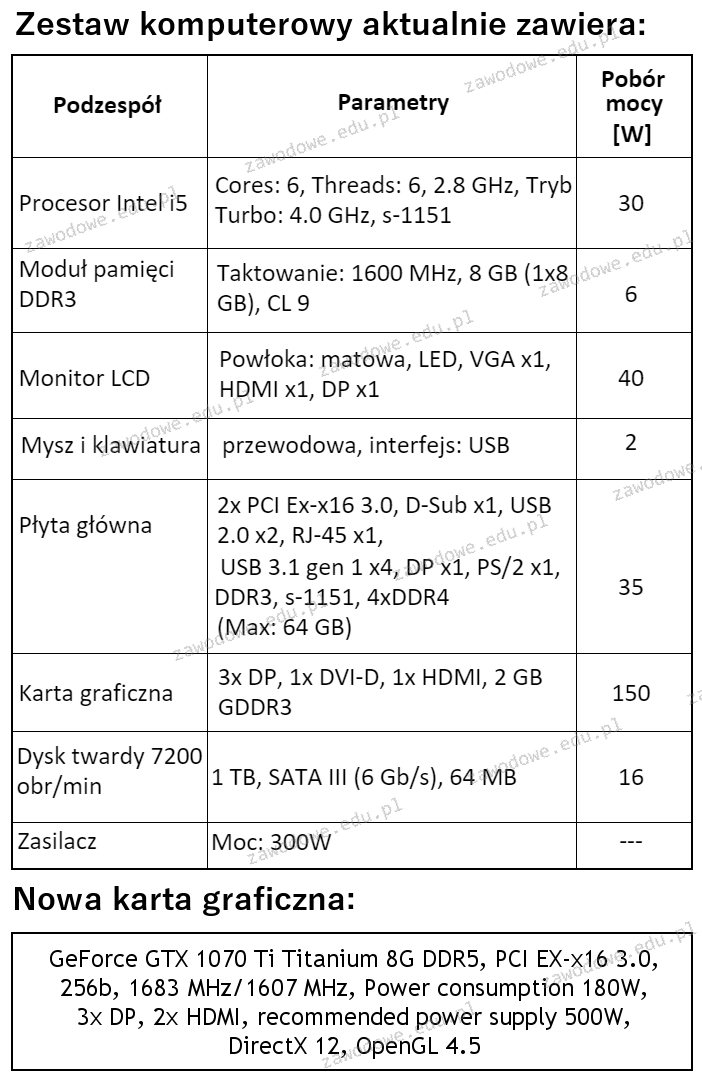

W zestawie komputerowym o parametrach wymienionych w tabeli konieczne jest zastąpienie karty graficznej nową, wskazaną w ramce. W związku z tym modernizacja tego komputera wymaga także wymiany

Zgodnie z normą PN-EN 50174, poziome okablowanie w systemie strukturalnym to segment okablowania pomiędzy

Który z protokołów należy do warstwy transportowej, działa bez nawiązywania połączenia i nie posiada mechanizmów weryfikujących poprawność dostarczania danych?

Podaj prefiks, który identyfikuje adresy globalne w protokole IPv6?

Który z portów na zaprezentowanej płycie głównej umożliwia podłączenie zewnętrznego dysku przez interfejs e-SATA?

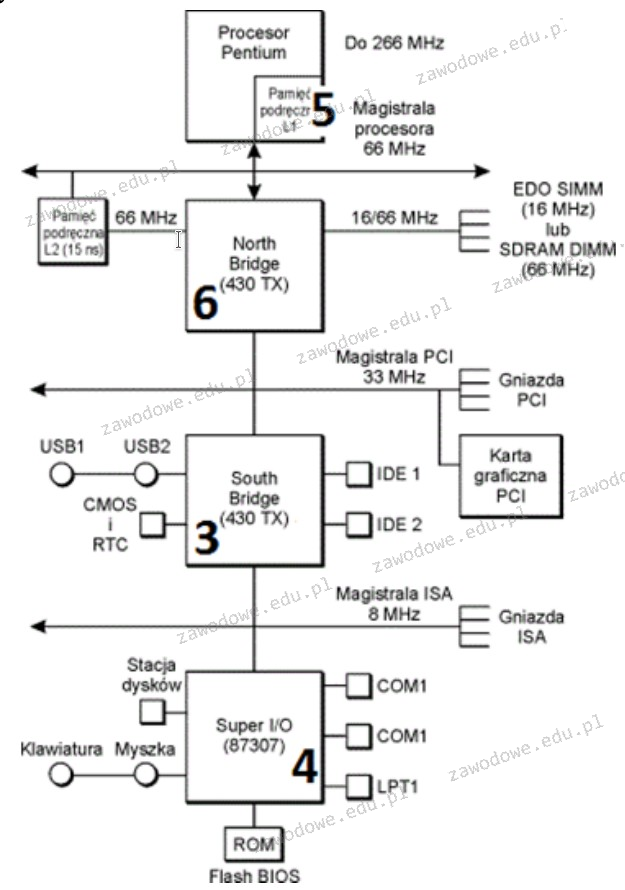

Część płyty głównej, która odpowiada za transmisję danych pomiędzy mikroprocesorem a pamięcią operacyjną RAM oraz magistralą karty graficznej, jest oznaczona na rysunku numerem

Dobrze zaplanowana sieć komputerowa powinna pozwalać na rozbudowę, co oznacza, że musi charakteryzować się

Jakie narzędzie będzie najbardziej odpowiednie do delikatnego wygięcia blachy obudowy komputera oraz przykręcenia śruby montażowej w trudno dostępnej lokalizacji?

Jakie urządzenie powinno być wykorzystane do pomiaru struktury połączeń w sieci lokalnej?

W sytuacji, gdy brakuje odpowiedniej ilości pamięci RAM do przeprowadzenia operacji, takiej jak uruchomienie aplikacji, system Windows pozwala na przeniesienie nieużywanych danych z pamięci RAM do pliku

Router przypisany do interfejsu LAN dysponuje adresem IP 192.168.50.1. Został on skonfigurowany w taki sposób, aby przydzielać komputerom wszystkie dostępne adresy IP w sieci 192.168.50.0 z maską 255.255.255.0. Jaką maksymalną liczbę komputerów można podłączyć w tej sieci?

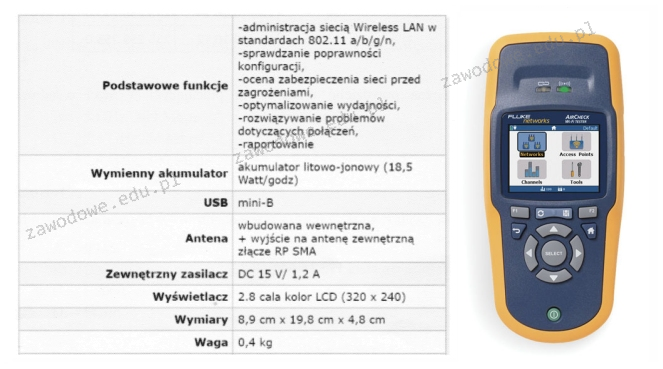

Jakie urządzenie diagnostyczne zostało zaprezentowane na ilustracji oraz opisane w specyfikacji zawartej w tabeli?

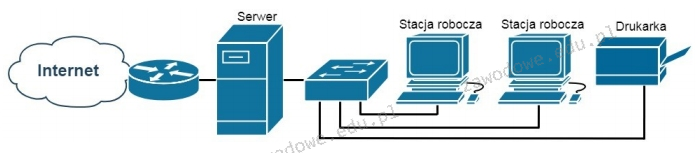

Która funkcja serwera Windows umożliwia użytkownikom końcowym sieci pokazanej na rysunku dostęp do Internetu?

Oblicz całkowity koszt materiałów potrzebnych do zbudowania sieci w topologii gwiazdy dla 3 komputerów z kartami sieciowymi, używając kabli o długości 2 m. Ceny materiałów są wskazane w tabeli.

| Nazwa elementu | Cena jednostkowa brutto |

|---|---|

| przełącznik | 80 zł |

| wtyk RJ-45 | 1 zł |

| przewód typu „skrętka" | 1 zł za 1 metr |

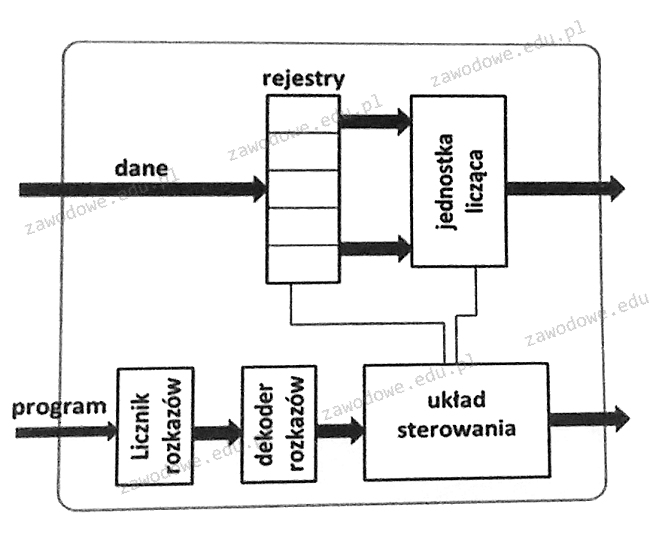

Rejestry przedstawione na diagramie procesora mają zadanie

Aby oddzielić komputery działające w sieci z tym samym adresem IPv4, które są podłączone do zarządzalnego przełącznika, należy przypisać

Jaki jest największy rozmiar pojedynczego datagramu IPv4, uwzględniając jego nagłówek?

Komunikat tekstowy BIOS POST od firmy Award o treści "Display switch is set incorrectly" sugeruje

Jaki rodzaj portu może być wykorzystany do podłączenia zewnętrznego dysku do laptopa?

AppLocker to funkcjonalność dostępna w systemach Windows Server, która umożliwia