Pytanie 1

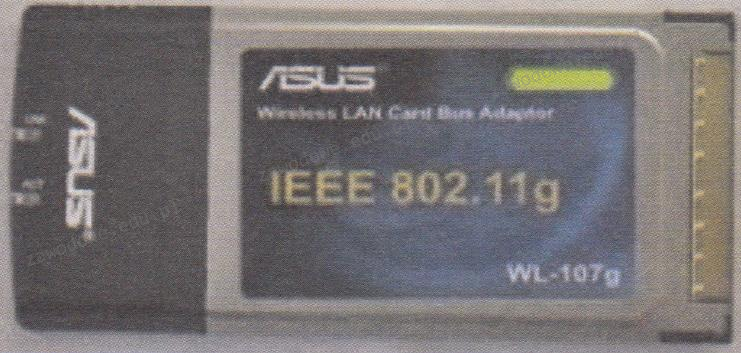

Karta sieciowa przedstawiona na ilustracji ma zdolność przesyłania danych z maksymalną prędkością

Wynik: 14/40 punktów (35,0%)

Wymagane minimum: 20 punktów (50%)

Karta sieciowa przedstawiona na ilustracji ma zdolność przesyłania danych z maksymalną prędkością

Korzystając z polecenia systemowego ipconfig, można skonfigurować

Jakie jest najwyższe możliwe tempo odczytu płyt CD-R w urządzeniu o oznaczeniu x48?

Zgodnie z wytycznymi dotyczącymi karty graficznej, jej możliwości pracy z systemem AGP 2X/4X pozwalają na

Jakiego narzędzia należy użyć do montażu końcówek kabla UTP w gnieździe keystone z zaciskami typu 110?

Wartość wyrażana w decybelach, będąca różnicą pomiędzy mocą sygnału przekazywanego w parze zakłócającej a mocą sygnału generowanego w parze zakłócanej to

Zanim zainstalujesz sterownik dla urządzenia peryferyjnego, system operacyjny Windows powinien weryfikować, czy sterownik ma ważny podpis

Jakim protokołem jest protokół dostępu do sieci pakietowej o maksymalnej prędkości 2 Mbit/s?

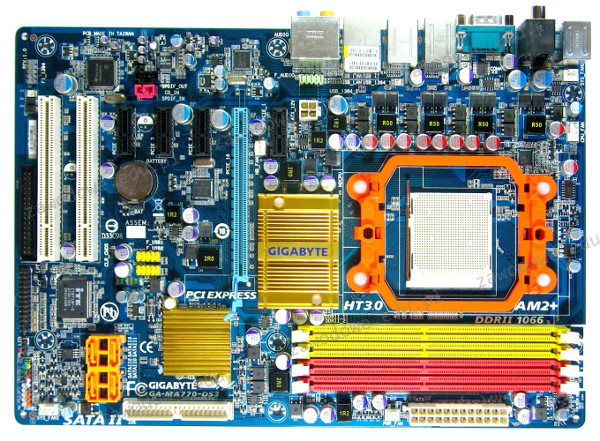

Jakie złącze umożliwia przesył danych między przedstawioną na ilustracji płytą główną a urządzeniem zewnętrznym, nie dostarczając jednocześnie zasilania do tego urządzenia przez interfejs?

Jaki typ złącza powinien być zastosowany w przewodzie UTP Cat 5e, aby połączyć komputer z siecią?

Pamięć podręczna Intel Smart Cache, która znajduje się w procesorach wielordzeniowych, takich jak Intel Core Duo, to pamięć

Zasady dotyczące filtracji ruchu w firewallu są ustalane w postaci

Jakie polecenie umożliwia wyświetlanie oraz modyfikację tabel translacji adresów IP do adresów fizycznych?

W normie PN-EN 50174 nie znajdują się wytyczne dotyczące

Wskaź zestaw do diagnostyki logicznych układów elektronicznych umiejscowionych na płycie głównej komputera, który nie reaguje na próby uruchomienia zasilania?

Który z protokołów umożliwia bezpieczne połączenie klienta z zachowaniem anonimowości z witryną internetową banku?

Który z parametrów należy użyć w poleceniu netstat, aby uzyskać statystyki interfejsu sieciowego dotyczące liczby przesłanych oraz odebranych bajtów i pakietów?

Wyjście audio dla słuchawek lub głośników minijack na karcie dźwiękowej oznaczone jest jakim kolorem?

Jednym z rezultatów realizacji podanego polecenia jest

| sudo passwd -n 1 -x 5 test |

Atak DDoS (z ang. Distributed Denial of Service) na serwer może spowodować

Który z poniższych mechanizmów zapewni najwyższy stopień ochrony sieci bezprzewodowych w standardzie 802.11n?

Która z podanych właściwości kabla koncentrycznego RG-58 sprawia, że obecnie nie jest on używany do tworzenia lokalnych sieci komputerowych?

Jakie znaczenie ma parametr NEXT w kontekście pomiarów systemów okablowania strukturalnego?

W topologii fizycznej w kształcie gwiazdy, wszystkie urządzenia działające w sieci są

Który z podanych adresów IP należy do kategorii adresów prywatnych?

Który adres IP jest przypisany do klasy A?

Aby aktywować funkcję S.M.A.R.T. dysku twardego, która odpowiada za monitorowanie i wczesne ostrzeganie przed awariami, należy skorzystać z

Urządzenie, które pozwala komputerom na bezprzewodowe łączenie się z siecią komputerową przewodową, to

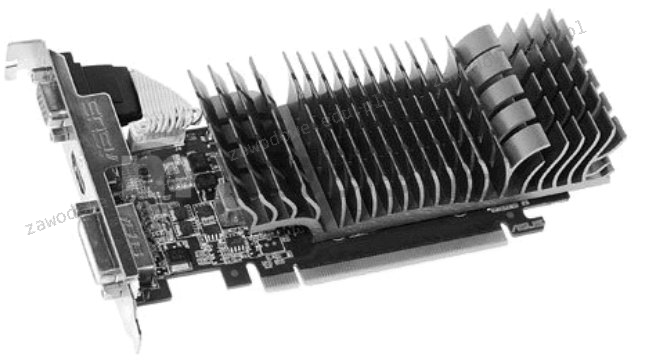

Karta rozszerzeń zaprezentowana na rysunku ma system chłodzenia

Niskopoziomowe formatowanie dysku IDE HDD polega na

Instalacja systemów Linuks oraz Windows 7 przebiegła bez żadnych problemów. Systemy zainstalowały się poprawnie z domyślnymi ustawieniami. Na tym samym komputerze, przy tej samej konfiguracji, podczas instalacji systemu Windows XP pojawił się komunikat o braku dysków twardych, co może sugerować

Aby zapewnić użytkownikom Active Directory możliwość logowania i korzystania z zasobów tej usługi w sytuacji awarii kontrolera domeny, trzeba

Licencja na Office 365 PL Personal (na 1 stanowisko, subskrypcja na 1 rok) ESD jest przypisana do

Jaka liczba hostów może być zaadresowana w podsieci z adresem 192.168.10.0/25?

Symbol graficzny przedstawiony na ilustracji oznacza jaką bramkę logiczną?

Aby odzyskać dane z dysku, który został sformatowany, warto użyć programu typu

W doborze zasilacza do komputera kluczowe znaczenie

Jakie narzędzie służy do usuwania izolacji z włókna światłowodowego?

Do właściwego funkcjonowania procesora konieczne jest podłączenie złącza zasilania 4-stykowego lub 8-stykowego o napięciu

Aby połączyć projektor multimedialny z komputerem, nie można zastosować złącza