Pytanie 1

Jak nazywa się jednostka danych PDU w warstwie sieciowej modelu ISO/OSI?

Wynik: 9/40 punktów (22,5%)

Wymagane minimum: 20 punktów (50%)

Jak nazywa się jednostka danych PDU w warstwie sieciowej modelu ISO/OSI?

Kable światłowodowe nie są szeroko używane w lokalnych sieciach komputerowych z powodu

Jaką maksymalną liczbę adresów można przypisać urządzeniom w sieci 10.0.0.0/22?

Które polecenie w systemie Windows Server 2008 pozwala na przekształcenie serwera w kontroler domeny?

Czym jest procesor Athlon 2800+?

Kiedy podczas startu systemu z BIOSu firmy AWARD komputer wyemitował długi dźwięk oraz dwa krótkie, to oznacza, że wystąpił błąd?

Jakie jest zadanie usługi DNS?

Czym jest licencja OEM?

Oprogramowanie, które jest dodatkiem do systemu Windows i ma na celu ochronę przed oprogramowaniem szpiegującym oraz innymi niechcianymi elementami, to

Jak określa się w systemie Windows profil użytkownika, który jest tworzony przy pierwszym logowaniu do komputera i zapisywany na lokalnym dysku twardym, a wszelkie jego modyfikacje dotyczą tylko tego konkretnego komputera?

Jaką konfigurację sieciową może mieć komputer, który należy do tej samej sieci LAN, co komputer z adresem 10.8.1.10/24?

Dodatkowe właściwości rezultatu operacji przeprowadzanej przez jednostkę arytmetyczno-logiczne ALU obejmują

Najskuteczniejszym sposobem na ochronę komputera przed wirusami jest zainstalowanie

Jakie zastosowanie ma oprogramowanie Microsoft Hyper-V?

Dane z twardego dysku HDD, którego sterownik silnika SM jest uszkodzony, można odzyskać

Jakie polecenie pozwala na uzyskanie adresów fizycznych dla kart sieciowych w systemie?

Aby podłączyć kabel w module Keystone, jakie narzędzie należy zastosować?

W drukarce laserowej do trwałego utrwalania druku na papierze wykorzystuje się

Na ilustracji widoczna jest pamięć operacyjna

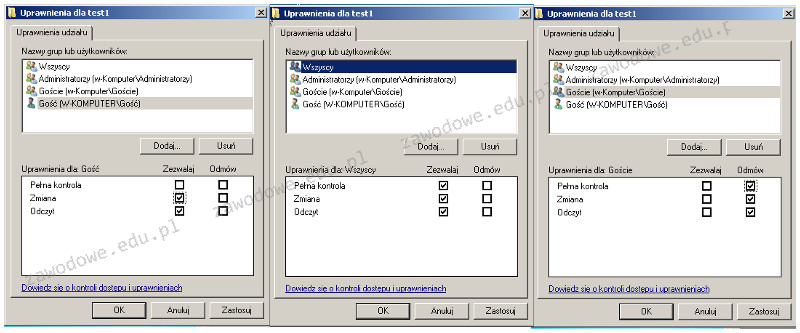

Użytkownik o nazwie Gość należy do grupy o nazwie Goście. Grupa Goście jest częścią grupy Wszyscy. Jakie ma uprawnienia użytkownik Gość w folderze test1?

Jednym z zaleceń w zakresie ochrony przed wirusami jest przeprowadzanie skanowania całego systemu. W związku z tym należy skanować komputer

Na zdjęciu widać kartę

Zawarty w listingach kod zawiera instrukcje pozwalające na

Jak należy ustawić w systemie Windows Server 2008 parametry protokołu TCP/IP karty sieciowej, aby komputer mógł jednocześnie łączyć się z dwiema różnymi sieciami lokalnymi posiadającymi odrębne adresy IP?

Polecenie grep w systemie Linux pozwala na

Jakie korzyści płyną z zastosowania systemu plików NTFS?

Interfejs SATA 2 (3Gb/s) oferuje prędkość transferu

Jaką komendę należy wpisać w miejsce kropek, aby w systemie Linux wydłużyć standardowy odstęp czasowy między kolejnymi wysyłanymi pakietami przy użyciu polecenia ping?

Proces zapisywania kluczy rejestru do pliku określamy jako

Jeżeli szybkość pobierania danych z sieci wynosi 8 Mb/s, to w ciągu 6 s możliwe jest pobranie pliku o maksymalnej wielkości równej

Zarządzaniem drukarkami w sieci, obsługiwaniem zadań drukowania oraz przyznawaniem uprawnień do drukarek zajmuje się serwer

Aby zrealizować transfer danych pomiędzy siecią w pracowni a siecią ogólnoszkolną, która ma inną adresację IP, należy zastosować

Jaki jest największy rozmiar pojedynczego datagramu IPv4, uwzględniając jego nagłówek?

Aby użytkownik laptopa z systemem Windows 7 lub nowszym mógł korzystać z drukarki przez sieć WiFi, musi zainstalować drukarkę na porcie

Jakiej klasy należy adres IP 130.140.0.0?

W trakcie użytkowania przewodowej myszy optycznej wskaźnik nie reaguje na ruch urządzenia po podkładce, a kursor zmienia swoje położenie dopiero po właściwym ustawieniu myszy. Te symptomy sugerują uszkodzenie

Który z protokołów umożliwia terminalowe połączenie ze zdalnymi urządzeniami, zapewniając jednocześnie transfer danych w zaszyfrowanej formie?

Aby naprawić zasilacz laptopa poprzez wymianę kondensatorów, jakie narzędzie powinno się wykorzystać?

Jakie zabezpieczenie w dokumentacji technicznej określa mechanizm zasilacza komputerowego zapobiegający przegrzaniu urządzenia?

Jaki element sieci SIP określamy jako telefon IP?