Pytanie 1

Po zainstalowaniu systemu Linux, użytkownik pragnie skonfigurować kartę sieciową poprzez wprowadzenie ustawień dotyczących sieci. Jakie działanie należy podjąć, aby to osiągnąć?

Wynik: 22/40 punktów (55,0%)

Wymagane minimum: 20 punktów (50%)

Po zainstalowaniu systemu Linux, użytkownik pragnie skonfigurować kartę sieciową poprzez wprowadzenie ustawień dotyczących sieci. Jakie działanie należy podjąć, aby to osiągnąć?

Przed dokonaniem zmian w rejestrze systemu Windows, w celu zapewnienia bezpieczeństwa pracy, należy najpierw

W przypadku planowania wykorzystania przestrzeni dyskowej komputera do przechowywania oraz udostępniania danych, takich jak pliki oraz aplikacje dostępne w internecie, a także ich zarządzania, komputer powinien być skonfigurowany jako

Wskaż rodzaj konserwacji, który powinien być przeprowadzony, gdy na wydruku z drukarki atramentowej pojawiają się smugi, kolory są nieprawidłowe lub brakuje niektórych barw.

Topologia fizyczna sieci komputerowej przedstawiona na ilustracji to topologia

Jakiego narzędzia należy użyć do montażu końcówek kabla UTP w gnieździe keystone z zaciskami typu 110?

W trakcie działania komputera doszło do samoczynnego twardego resetu. Przyczyną tego resetu może być najprawdopodobniej

Jakie polecenie powinien wydać root w systemie Ubuntu Linux, aby zaktualizować wszystkie pakiety (cały system) do najnowszej wersji, łącznie z nowym jądrem?

Active Directory w systemach MS Windows Server 2000 oraz MS Windows Server 2003 to

Aby zredukować kluczowe zagrożenia związane z bezpieczeństwem podczas pracy na komputerze podłączonym do sieci Internet, należy przede wszystkim

Który z poniższych systemów operacyjnych nie jest wspierany przez system plików ext4?

Jakie urządzenie należy zastosować do pomiaru mocy zużywanej przez komputer?

W ustawieniach haseł w systemie Windows Server została dezaktywowana możliwość wymogu dotyczącego złożoności hasła. Z jakiej minimalnej liczby znaków powinno składać się hasło użytkownika?

Jaki adres IPv4 identyfikuje urządzenie funkcjonujące w sieci o adresie 14.36.64.0/20?

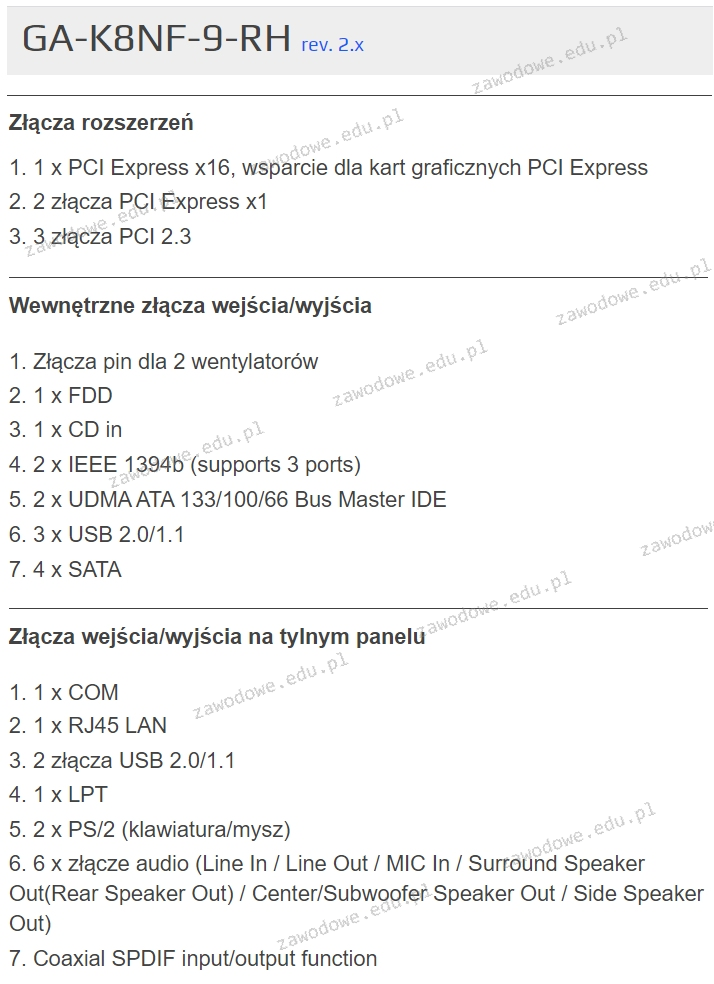

Na ilustracji ukazano fragment dokumentacji technicznej płyty głównej GA-K8NF-9-RH rev. 2.x. Z informacji wynika, że maksymalna liczba kart rozszerzeń, które można zainstalować (pomijając złącza USB), wynosi

Wskaż błędny sposób podziału dysku MBR na partycje

W kontekście adresacji IPv6, użycie podwójnego dwukropka służy do

Na podstawie wskazanego cennika oblicz, jaki będzie łączny koszt brutto jednego podwójnego natynkowego gniazda abonenckiego w wersji dwumodułowej?

| Lp. | Nazwa | j.m. | Cena jednostkowa brutto |

|---|---|---|---|

| 1. | Puszka natynkowa 45x45mm dwumodułowa | szt. | 4,00 zł |

| 2. | Ramka + suport 45x45mm dwumodułowa | szt. | 4,00 zł |

| 3. | Adapter 22,5x45mm do modułu keystone | szt. | 3,00 zł |

| 4. | Moduł keystone RJ45 kategorii 5e | szt. | 7,00 zł |

W jakiej topologii sieci komputerowej każdy komputer jest połączony z dokładnie dwoma innymi komputerami, bez żadnych dodatkowych urządzeń aktywnych?

Wartość wyrażana w decybelach, będąca różnicą pomiędzy mocą sygnału przekazywanego w parze zakłócającej a mocą sygnału generowanego w parze zakłócanej to

Diagnostykę systemu Linux można przeprowadzić za pomocą komendy

Czym jest VOIP?

Na przedstawionym rysunku widoczna jest karta rozszerzeń z systemem chłodzenia

Jakie jest właściwe IP dla maski 255.255.255.0?

Aby poprawić niezawodność oraz efektywność przesyłania danych na serwerze, należy

Osoba korzystająca z komputera, która testuje łączność sieciową używając polecenia ping, uzyskała wynik przedstawiony na rysunku. Jakie może być źródło braku reakcji serwera przy pierwszej próbie, zakładając, że adres domeny wp.pl to 212.77.100.101?

Analiza uszkodzonych elementów komputera poprzez ocenę stanu wyjściowego układu cyfrowego pozwala na

Jaką licencję ma wolne i otwarte oprogramowanie?

W drukarce laserowej do trwałego utrwalania druku na papierze wykorzystuje się

Jakiego parametru w poleceniu ping należy użyć, aby uzyskać rezultat pokazany na zrzucie ekranu?

Po zainstalowaniu Systemu Windows 7 dokonano zmiany w BIOS-ie komputera, skonfigurowano dysk SATA z AHCI na IDE. Po ponownym uruchomieniu systemu komputer będzie

Grupa, w której członkom można nadawać uprawnienia jedynie w obrębie tej samej domeny, co domena nadrzędna lokalnej grupy domeny, nosi nazwę grupa

Jakie środowisko graficzne zaprojektowane dla systemu Linux ma najniższe wymagania dotyczące pamięci RAM?

Jakie napięcie zasilające mają pamięci DDR2?

Aby przywrócić dane, które zostały usunięte dzięki kombinacji klawiszy Shift+Delete, trzeba

Wykonanie na komputerze z systemem Windows kolejno poleceń ```ipconfig /release``` oraz ```ipconfig /renew``` umożliwi zweryfikowanie, czy usługa w sieci funkcjonuje poprawnie

Jakie urządzenie powinno być użyte, aby poprawić zasięg sieci bezprzewodowej w obiekcie?

Jakie połączenie bezprzewodowe należy zastosować, aby mysz mogła komunikować się z komputerem?

Jaką funkcję pełni serwer ISA w systemie Windows?

Symbol przedstawiony na ilustracji oznacza produkt