Pytanie 1

W ustawieniach haseł w systemie Windows Server została dezaktywowana możliwość wymogu dotyczącego złożoności hasła. Z jakiej minimalnej liczby znaków powinno składać się hasło użytkownika?

Wynik: 17/40 punktów (42,5%)

Wymagane minimum: 20 punktów (50%)

W ustawieniach haseł w systemie Windows Server została dezaktywowana możliwość wymogu dotyczącego złożoności hasła. Z jakiej minimalnej liczby znaków powinno składać się hasło użytkownika?

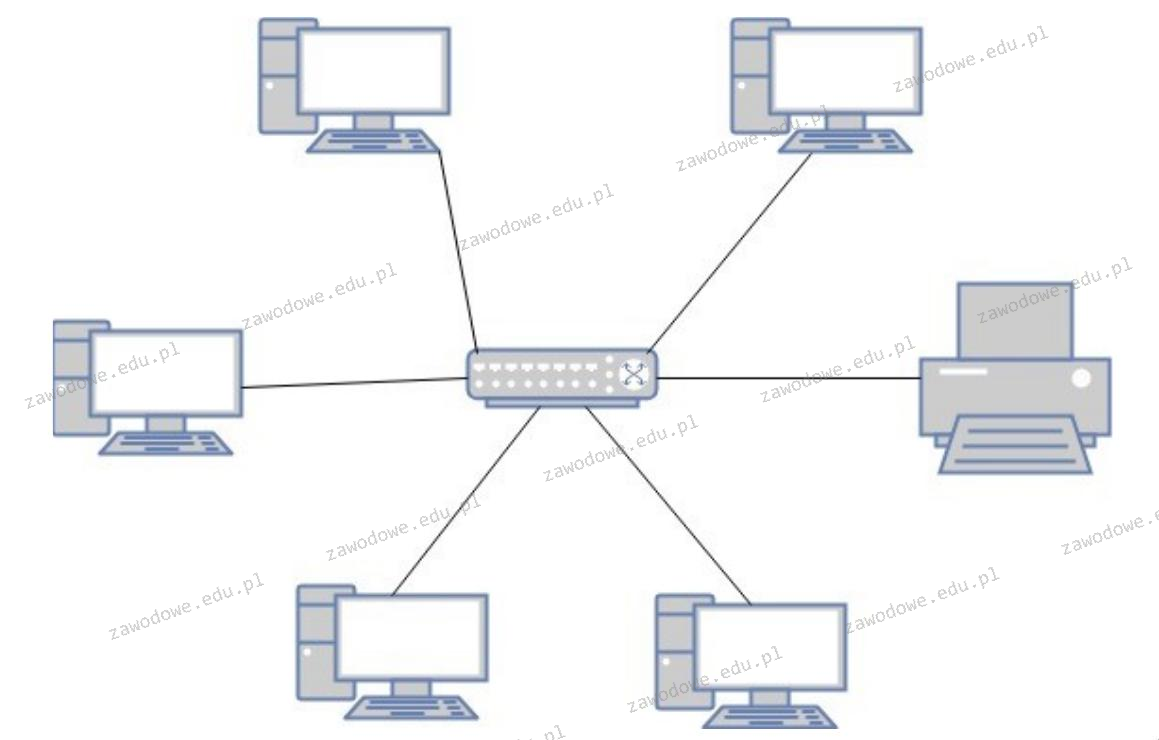

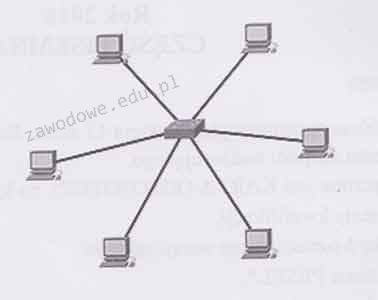

Jaką fizyczną topologię sieci komputerowej przedstawia ilustracja?

Jakiego działania nie wykonują serwery plików?

Który z wewnętrznych protokołów routingu bazuje na metodzie wektora odległości?

Który z protokołów służy do synchronizacji czasu?

Jakim interfejsem można uzyskać transmisję danych o maksymalnej przepustowości 6 Gb/s?

Aby zabezpieczyć system przed oprogramowaniem o zdolności do samoreplikacji, należy zainstalować

Jakim protokołem komunikacyjnym, który gwarantuje niezawodne przesyłanie danych, jest protokół

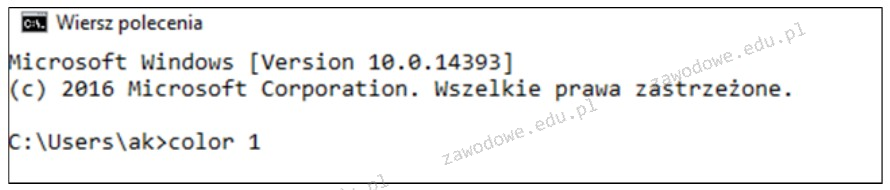

W systemie Windows zastosowanie zaprezentowanego polecenia spowoduje chwilową modyfikację koloru

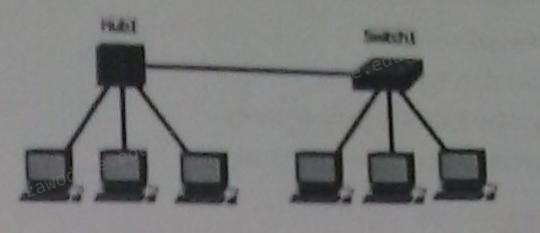

Ile domen kolizyjnych znajduje się w sieci przedstawionej na rysunku?

Wykonanie polecenia net use z:\\192.168.20.2\data /delete, spowoduje

Po zainstalowaniu z domyślnymi uprawnieniami, system Windows XP nie obsługuje formatu systemu plików

Jak nazywa się zestaw usług internetowych dla systemów operacyjnych z rodziny Microsoft Windows, który umożliwia działanie jako serwer FTP oraz serwer WWW?

Narzędzie pokazane na ilustracji służy do

Protokołem umożliwiającym dostęp do sieci pakietowej o prędkości nieprzekraczającej 2 Mbit/s jest protokół

Podczas procesu zamykania systemu operacyjnego na wyświetlaczu pojawił się błąd, znany jako bluescreen 0x000000F3 Bug Check 0xF3 DISORDERLY_SHUTDOWN - nieudane zakończenie pracy systemu, spowodowane brakiem pamięci. Co może sugerować ten błąd?

Określ zakres adresów IP z klasy A, który wykorzystywany jest do adresacji prywatnej w sieciach komputerowych?

Aby wymusić na użytkownikach lokalnych systemów z rodziny Windows Server regularną zmianę hasła oraz stosowanie haseł o odpowiedniej długości i spełniających wymagania dotyczące złożoności, należy ustawić

Jakie polecenie należy wykorzystać, aby zmienić właściciela pliku w systemie Linux?

Dane dotyczące kont użytkowników w systemie Linux są przechowywane w pliku

Który z podanych adresów należy do kategorii publicznych?

Które z poniższych poleceń w systemie Linux służy do zmiany uprawnień pliku?

chmod jest używane w systemach operacyjnych Unix i Linux do zmiany uprawnień plików i katalogów. Uprawnienia te określają, kto i w jaki sposób może czytać, zapisywać lub wykonywać dany plik. Polecenie to jest niezwykle przydatne w kontekście zarządzania bezpieczeństwem i dostępem do zasobów na serwerach i komputerach osobistych. Przykładowo, aby nadać pełne uprawnienia właścicielowi pliku, ale ograniczyć je dla innych użytkowników, można użyć polecenia chmod 700 nazwa_pliku. Ten sposób nadawania uprawnień jest bardzo elastyczny i pozwala na dokładne skonfigurowanie dostępu zgodnie z potrzebami użytkownika lub politykami firmy. Warto także wspomnieć, że chmod wspiera zarówno notację symboliczną (np. chmod u+x) jak i ósemkową (np. chmod 755), co ułatwia jego stosowanie w różnych scenariuszach. Dzięki temu narzędziu administratorzy systemów mogą skutecznie zarządzać dostępem do plików, co jest kluczowe dla utrzymania bezpieczeństwa danych.Zjawisko przekazywania tokena (ang. token) występuje w sieci o fizycznej strukturze

Jakie z podanych urządzeń stanowi część jednostki centralnej?

Która z licencji pozwala każdemu użytkownikowi na wykorzystywanie programu bez ograniczeń związanych z prawami autorskimi?

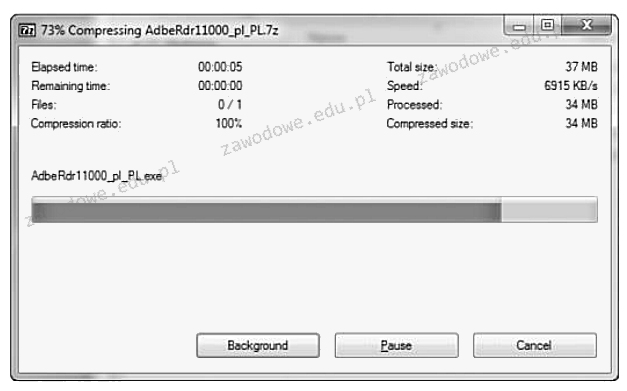

Na dołączonym obrazku pokazano działanie

Równoległy interfejs, w którym magistrala składa się z 8 linii danych, 4 linii sterujących oraz 5 linii statusowych, nie zawiera linii zasilających i umożliwia transmisję na odległość do 5 metrów, pod warunkiem, że przewody sygnałowe są skręcane z przewodami masy; w przeciwnym razie limit wynosi 2 metry, nazywa się

Wskaż komponent, który nie jest zgodny z płytą główną o parametrach przedstawionych w tabeli

| Podzespół | Parametry |

|---|---|

| Płyta główna GIGABYTE | 4x DDR4, 4x PCI-E 16x, RAID, HDMI, D-Port, D-SUB, 2x USB 3.1, 8 x USB 2.0, S-AM3+ |

Ile sieci obejmują komputery z adresami IP i maskami sieci podanymi w tabeli?

| Adres IPv4 | Maska |

|---|---|

| 10.120.16.10 | 255.255.0.0 |

| 10.120.18.16 | 255.255.0.0 |

| 10.110.16.18 | 255.255.255.0 |

| 10.110.16.14 | 255.255.255.0 |

| 10.130.16.12 | 255.255.255.0 |

Administrator systemu Windows zauważył znaczne spowolnienie działania komputera spowodowane niską ilością dostępnej pamięci RAM. W celu zidentyfikowania programu, który zużywa jej najwięcej, powinien skorzystać z narzędzia

Aby zwiększyć wydajność komputera, można zainstalować procesor obsługujący technologię Hyper-Threading, która pozwala na

Który standard w połączeniu z odpowiednią kategorią kabla skrętki jest skonfigurowany w taki sposób, aby umożliwiać maksymalny transfer danych?

Jakie zakresy częstotliwości określa klasa EA?

Jednym z programów stosowanych do tworzenia kopii zapasowych partycji oraz dysków jest

Schemat ilustruje fizyczną strukturę

Która z poniższych informacji odnosi się do profilu tymczasowego użytkownika?

Aby przeprowadzić aktualizację zainstalowanego systemu operacyjnego Linux Ubuntu, należy wykorzystać komendę

Złośliwe oprogramowanie, które może umożliwić atak na zainfekowany komputer, np. poprzez otwarcie jednego z portów, to

Sygnatura (ciąg bitów) 55AA (w systemie szesnastkowym) kończy tablicę partycji. Jaka jest odpowiadająca jej wartość w systemie binarnym?

Aby chronić urządzenia w sieci LAN przed przepięciami oraz różnicami potencjałów, które mogą się pojawić w trakcie burzy lub innych wyładowań atmosferycznych, należy zastosować