Pytanie 1

Podczas skanowania reprodukcji obrazu z magazynu, na skanie obrazu ukazały się regularne wzory, zwane morą. Jakiej funkcji skanera należy użyć, aby usunąć te wzory?

Wynik: 25/40 punktów (62,5%)

Wymagane minimum: 20 punktów (50%)

Podczas skanowania reprodukcji obrazu z magazynu, na skanie obrazu ukazały się regularne wzory, zwane morą. Jakiej funkcji skanera należy użyć, aby usunąć te wzory?

Liczba 5110 w zapisie binarnym wygląda jak

Brak odpowiedzi na to pytanie.

Aby utworzyć obraz dysku twardego, można skorzystać z programu

Analiza uszkodzonych elementów komputera poprzez ocenę stanu wyjściowego układu cyfrowego pozwala na

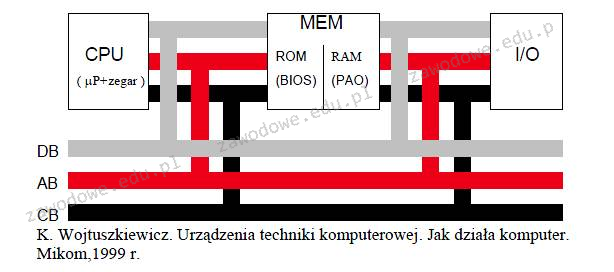

Który z komponentów komputera, gdy zasilanie jest wyłączone, zachowuje program inicjujący uruchamianie systemu operacyjnego?

Dwie stacje robocze w tej samej sieci nie mają możliwości komunikacji. Która z poniższych okoliczności może być przyczyną tego problemu?

Aby kontrolować ilość transferu w sieci, administrator powinien zastosować program rodzaju

ACPI to akronim, który oznacza

W przypadku awarii którego urządzenia w sieci lokalnej, cała sieć przestaje działać w topologii magistrali?

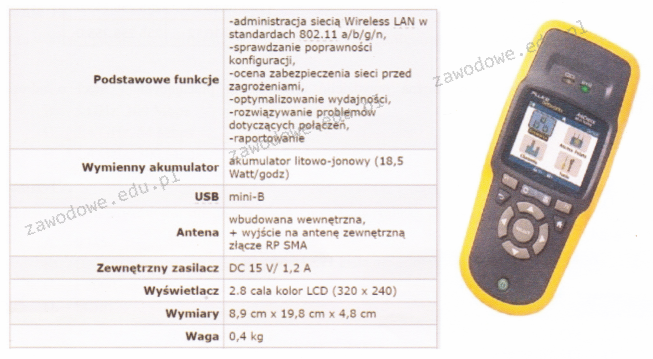

Jakie urządzenie diagnostyczne jest pokazane na ilustracji oraz opisane w specyfikacji zawartej w tabeli?

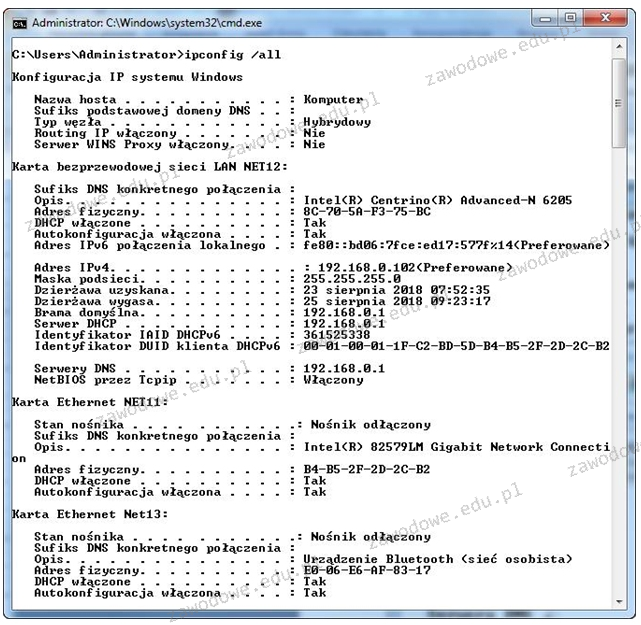

Analizując przedstawione wyniki konfiguracji zainstalowanych kart sieciowych na komputerze, można zauważyć, że

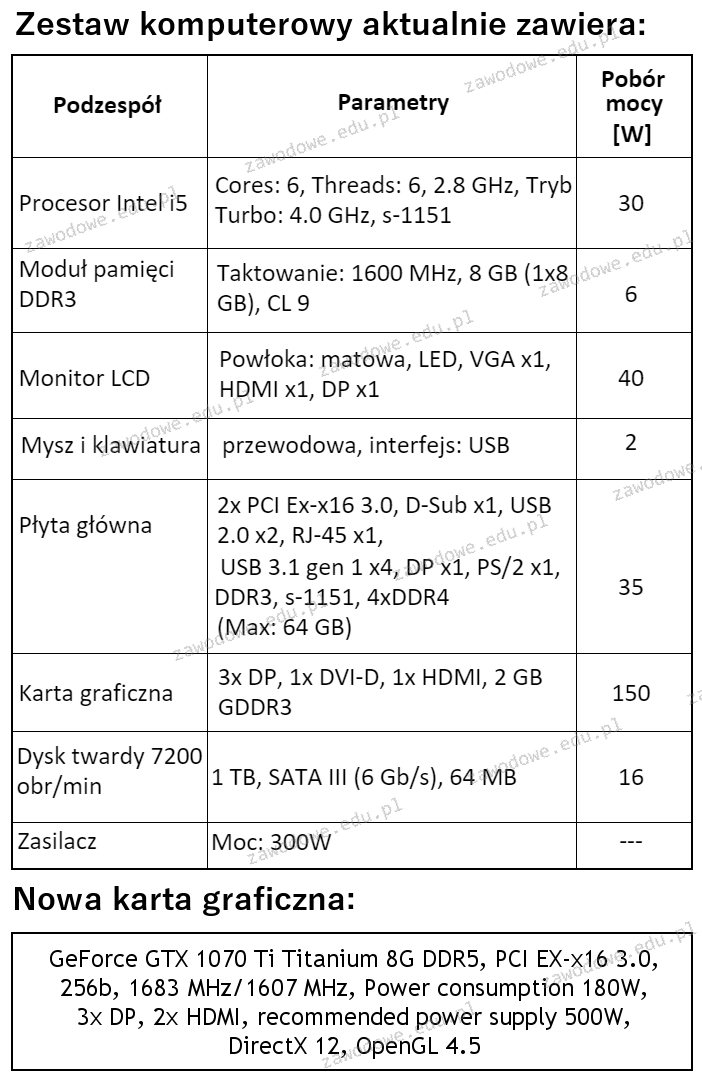

W zestawie komputerowym o parametrach wymienionych w tabeli konieczne jest zastąpienie karty graficznej nową, wskazaną w ramce. W związku z tym modernizacja tego komputera wymaga także wymiany

Program "VirtualPC", dostępny do pobrania z witryny Microsoft, jest przeznaczony do korzystania:

Dysk z systemem plików FAT32, na którym regularnie przeprowadza się działania usuwania starych plików oraz dodawania nowych plików, doświadcza

W systemie binarnym liczba 51(10) przyjmuje formę

Aby zmierzyć tłumienie światłowodowego łącza w dwóch zakresach długości fal 1310 nm i 1550 nm, należy zastosować

Jaką jednostką określa się szybkość przesyłania danych w sieciach komputerowych?

Który z poniższych mechanizmów zagwarantuje najwyższy poziom ochrony w sieciach bezprzewodowych opartych na standardzie 802.11n?

Polecenie Gpresult

Wskaż komponent, który reguluje wartość napięcia pochodzącego z sieci elektrycznej, wykorzystując transformator do przeniesienia energii między dwoma obwodami elektrycznymi z zastosowaniem zjawiska indukcji magnetycznej?

Który z poniższych adresów IPv4 wraz z prefiksem reprezentuje adres sieci?

Jakie czynności nie są realizowane przez system operacyjny?

Aby przygotować ikony zaprezentowane na załączonym obrazku do wyświetlania na Pasku zadań w systemie Windows, należy skonfigurować

Wykonanie polecenia ipconfig /renew w trakcie ustawiania interfejsów sieciowych doprowadzi do

Jakie narzędzie w wierszu poleceń służy do testowania oraz diagnostyki serwerów DNS?

Aby przetestować funkcjonowanie serwera DNS w systemach Windows Server, można skorzystać z narzędzia nslookup. Jeśli w poleceniu podamy nazwę komputera, np. nslookup host.domena.com, to dojdzie do weryfikacji

Jakie składniki systemu komputerowego wymagają utylizacji w wyspecjalizowanych zakładach przetwarzania z powodu obecności niebezpiecznych substancji lub pierwiastków chemicznych?

Procesor RISC to procesor o

Podczas analizy ruchu sieciowego przy użyciu sniffera zauważono, że urządzenia przesyłają dane na portach 20 oraz 21. Przyjmując standardową konfigurację, oznacza to, że analizowanym protokołem jest protokół

Program do diagnostyki komputera pokazał komunikat NIC ERROR. Co oznacza ten komunikat w kontekście uszkodzenia karty?

Jakie polecenie w systemie Linux służy do przypisania adresu IP oraz maski podsieci dla interfejsu eth0?

Czym jest kopia różnicowa?

Zgodnie z ustawą z 14 grudnia 2012 roku o odpadach, wymagane jest

Wskaż złącze, które nie jest obecne w zasilaczach ATX?

Kable łączące dystrybucyjne punkty kondygnacyjne z głównym punktem dystrybucji są określane jako

Wartość liczby 1100112 zapisanej w systemie dziesiętnym wynosi

W systemie Linux polecenie chmod 321 start spowoduje przyznanie poniższych uprawnień plikowi start:

Jakie polecenie pozwala na uzyskanie informacji o bieżących połączeniach TCP oraz o portach źródłowych i docelowych?

Jakie stwierdzenie o routerach jest poprawne?

Do konserwacji elementów optycznych w komputerach zaleca się zastosowanie