Pytanie 1

W systemie Windows, aby założyć nową partycję podstawową, trzeba skorzystać z przystawki

Wynik: 16/40 punktów (40,0%)

Wymagane minimum: 20 punktów (50%)

W systemie Windows, aby założyć nową partycję podstawową, trzeba skorzystać z przystawki

Jakie urządzenie pozwala na połączenie lokalnej sieci komputerowej z Internetem?

Umożliwienie stacjom roboczym Windows, OS X oraz Linux korzystania z usług drukowania Linuxa i serwera plików zapewnia serwer

Który z poniższych protokołów nie jest wykorzystywany do konfiguracji wirtualnej sieci prywatnej?

Nie można uruchomić systemu Windows z powodu błędu oprogramowania. Jak można przeprowadzić diagnozę i usunąć ten błąd w jak najmniej inwazyjny sposób?

Ile punktów abonenckich (2 x RJ45) powinno być zainstalowanych w biurze o powierzchni 49 m2, zgodnie z normą PN-EN 50167?

Który standard implementacji sieci Ethernet określa sieć wykorzystującą kabel koncentryczny, z maksymalną długością segmentu wynoszącą 185 m?

Jaki jest główny cel stosowania maski podsieci?

Zjawisko, w którym pliki przechowywane na dysku twardym są zapisywane w klastrach, które nie sąsiadują ze sobą, określane jest mianem

Jeśli sieć 172.16.6.0/26 zostanie podzielona na dwie równe podsieci, to ile adresowalnych hostów będzie w każdej z nich?

Który standard Ethernet określa Gigabit Ethernet dla okablowania UTP?

System S.M.A.R.T. jest wykorzystywany do nadzorowania działania oraz identyfikacji usterek

Wskaź, które zdanie dotyczące zapory sieciowej jest nieprawdziwe?

Który kolor żyły znajduje się w kablu skrętkowym?

Do jakiej grupy w systemie Windows Server 2008 powinien być przypisany użytkownik odpowiedzialny wyłącznie za archiwizację danych przechowywanych na serwerowym dysku?

W przedsiębiorstwie trzeba było zreperować 5 komputerów i serwer. Czas potrzebny na naprawę każdego z komputerów wyniósł 1,5 godziny, a serwera 2,5 godziny. Stawka za usługę to 100,00 zł za roboczogodzinę, a do tego doliczany jest podatek VAT w wysokości 23%. Jaka kwota brutto będzie należna za tę usługę?

Na załączonym zdjęciu znajduje się

Jaką maksymalną wartość rozplotu kabla UTP można uzyskać we wtyku RJ45 według normy PN-EN 50173?

Jakim protokołem komunikacyjnym w warstwie transportowej, który zapewnia niezawodność przesyłania pakietów, jest protokół

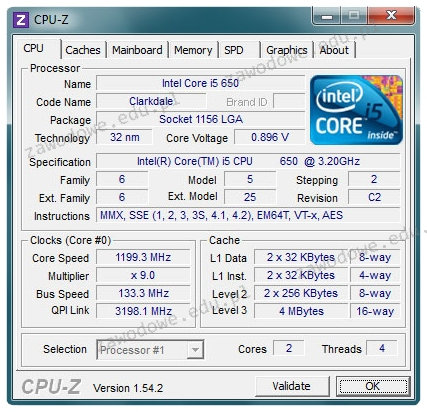

W dokumentacji technicznej procesora producent zamieścił wyniki analizy zrealizowanej przy użyciu programu CPU-Z. Z tych informacji wynika, że procesor dysponuje

W systemie Linux narzędzie, które umożliwia śledzenie trasy pakietów od źródła do celu, pokazując procentowe straty oraz opóźnienia, to

W jakim modelu płyty głównej można zainstalować procesor o wymienionych specyfikacjach?

| Intel Core i7-4790 3,6 GHz 8MB cache s. 1150 Box |

Pamięć Intel® Smart Cache, która jest wbudowana w procesory o wielu rdzeniach, takie jak Intel® Core TM Duo, to pamięć

Z powodu uszkodzenia kabla typu skrętka utracono dostęp między przełącznikiem a stacją roboczą. Który instrument pomiarowy powinno się wykorzystać, aby zidentyfikować i naprawić problem bez wymiany całego kabla?

Gdy komputer się uruchamia, na ekranie wyświetla się komunikat "CMOS checksum error press F1 to continue press DEL to setup". Naciśnięcie klawisza DEL spowoduje

Jaki skrót odpowiada poniższej masce podsieci: 255.255.248.0?

Najskuteczniejszym zabezpieczeniem sieci bezprzewodowej jest

Na wydrukach uzyskanych z drukarki laserowej można zauważyć pasma wzdłużne oraz powtarzające się defekty. Jedną z możliwych przyczyn niskiej jakości druku jest wada

Jakie są poszczególne elementy adresu globalnego IPv6 typu unicast pokazane na ilustracji?

| IPv6 | ||

|---|---|---|

| 1 | 2 | 3 |

| 48 bitów | 16 bitów | 64 bity |

W schemacie logicznym okablowania strukturalnego, zgodnie z terminologią polską zawartą w normie PN-EN 50174, cechą kondygnacyjnego punktu dystrybucyjnego jest to, że

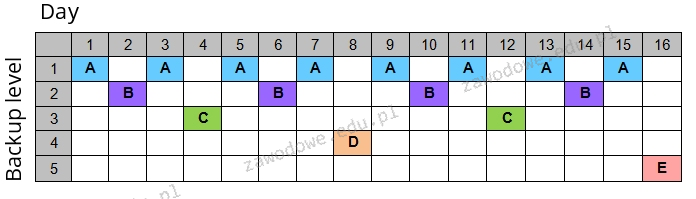

Strategia przedstawiona w diagramie dla tworzenia kopii zapasowych na nośnikach jest znana jako

Ile urządzeń będzie można zaadresować w każdej podsieci, jeśli sieć 172.16.6.0 zostanie podzielona przy pomocy maski /27 na jak największą liczbę podsieci?

Tester strukturalnego okablowania umożliwia weryfikację

W systemach Windows XP Pro/Windows Vista Business/Windows 7 Pro/Windows 8 Pro, funkcją zapewniającą ochronę danych dla użytkowników dzielących ten sam komputer, których informacje mogą być wykorzystywane wyłącznie przez nich, jest

Jakie urządzenie należy wykorzystać w sieci Ethernet, aby zredukować liczbę kolizji pakietów?

Który z protokołów NIE jest używany do ustawiania wirtualnej sieci prywatnej?

Jakie są korzyści płynące z użycia systemu plików NTFS?

W usłudze, jaką funkcję pełni protokół RDP?

Czym jest mapowanie dysków?

Impulsator pozwala na diagnozowanie uszkodzonych układów logicznych komputera między innymi poprzez